Cálculo de la Distancia de un Punto a una Recta

Calcular la distancia de un punto a una recta es una tarea muy común en cálculo y geometría. En la mayoría de los casos, necesitamos determinar cuán lejos está un punto de una línea recta, ya sea en un plano bidimensional o en un espacio tridimensional. Este cálculo es muy importante en muchas aplicaciones, como la navegación, la ingeniería y la cartografía.

En términos simples, la distancia de un punto a una recta es la longitud del segmento más corto que une el punto con la línea. Para calcularlo, primero debemos encontrar la ecuación de la recta y luego seguir los siguientes pasos:

- Calcular el vector dirección de la recta.

- Calcular el vector que va desde cualquier punto en la recta al punto dado.

- Proyectar este vector en el vector dirección de la recta.

- Calcular la longitud de la proyección como la distancia del punto a la recta.

Debemos tener en cuenta que la distancia de un punto a una recta es siempre positiva. Por lo tanto, si la proyección del vector resulta ser negativa, debemos tomar el valor absoluto para obtener la distancia correcta.

En resumen, el cálculo de la distancia de un punto a una recta es una técnica matemática importante que se utiliza en muchos campos profesionales. Al seguir los pasos descritos anteriormente, podemos determinar la distancia más corta entre un punto y una línea recta, lo que nos permite realizar cálculos precisos y tomar decisiones informadas en una variedad de situaciones diferentes.

¿Cuál es la fórmula para calcular la distancia de un punto a una recta?

La distancia de un punto a una recta es una medida fundamental en geometría analítica. La fórmula para calcular esta distancia se basa en la proyección ortogonal del punto sobre la recta. Para entender esto, es necesario recordar que una recta en el plano puede ser representada por una ecuación lineal de la forma Ax + By + C = 0, donde A, B y C son constantes y x, y son las coordenadas de cualquier punto sobre la recta.

Para calcular la distancia de un punto (x0, y0) a la recta, primero se debe encontrar la ecuación de la recta perpendicular que pase por el punto. Esta recta perpendicular tiene una ecuación de la forma Bx - Ay + D = 0, donde D es una constante que se encuentra a partir del punto (x0, y0). Por ejemplo, si la recta original es Ax + By + C = 0, entonces la recta perpendicular es -Bx + Ay + D = 0.

El siguiente paso es encontrar el punto de intersección entre la recta original y la recta perpendicular. Este punto tiene coordenadas (x1, y1) y puede ser encontrado resolviendo el sistema de ecuaciones formado por las dos ecuaciones de las rectas. Una vez obtenido este punto, la distancia entre el punto original y la recta es simplemente la distancia euclidiana entre los puntos (x0, y0) y (x1, y1).

La fórmula para la distancia entre dos puntos P(x1, y1) y Q(x2, y2) en un plano cartesiano es la raíz cuadrada de la sumatoria de los cuadrados de las diferencias de sus coordenadas, es decir, D(P,Q) = √((x2 - x1)² + (y2 - y1)²). Por lo tanto, la distancia de un punto a una recta puede ser calculada de la siguiente manera: D(punto, recta) = D(punto, punto de intersección) = √((x0 - x1)² + (y0 - y1)²).

En resumen, para calcular la distancia de un punto a una recta, es necesario encontrar la ecuación de la recta perpendicular que pase por el punto, hallar el punto de intersección entre esta recta y la recta original, y finalmente, calcular la distancia euclidiana entre ambos puntos. Esta fórmula es muy útil en diferentes contextos, especialmente en física y en geometría, y puede ser aplicada en problemas de posicionamiento de objetos o en el cálculo de trayectorias.

¿Qué significa la distancia de un punto a una recta?

La distancia de un punto a una recta es la distancia más corta entre el punto y cualquier punto de la recta. Esta distancia se conoce como distancia ortogonal debido a que la recta y la línea que une al punto y a la recta forman un ángulo recto.

Para calcular esta distancia ortogonal, se utiliza la fórmula siguiente: d(P,r) = |(ax + by + c)/((a^2+b^2)^(1/2))| , donde P es el punto, r es la recta, ax + by + c es la ecuación de la recta, y a y b son los coeficientes de las variables x e y en la ecuación de la recta.

A menudo, es necesario calcular la distancia de un punto a una recta en problemas relacionados con la geometría, la física y la ingeniería. Por ejemplo, en un problema de geometría, podemos querer saber la distancia de un punto a una recta que se utiliza como bisectriz para dividir un ángulo en dos partes iguales. En física, podemos querer calcular la distancia de un objeto a una línea de fuerza eléctrica o magnética para analizar su comportamiento. En ingeniería, podemos necesitar conocer la distancia de un punto a una línea de producción para colocar la maquinaria en el lugar adecuado.

En resumen, la distancia de un punto a una recta es una medida importante en situaciones en las que se requiere una medición precisa y precisa de la distancia entre un punto y una recta en un espacio tridimensional. Esta distancia se calcula utilizando una fórmula matemática, y puede ser utilizada en una variedad de campos, como la ingeniería, la física y la geometría.

¿Cómo se calcula la distancia entre los puntos?

El cálculo de la distancia entre dos puntos es una operación matemática que se utiliza en múltiples áreas. Por ejemplo, en el campo de la física, la geometría y la navegación, entre otros.

Para calcular la distancia entre dos puntos, es necesario conocer sus coordenadas cartesianas en el plano. En otras palabras, se deben tener los valores de la posición del punto en el eje horizontal (x) y en el eje vertical (y).

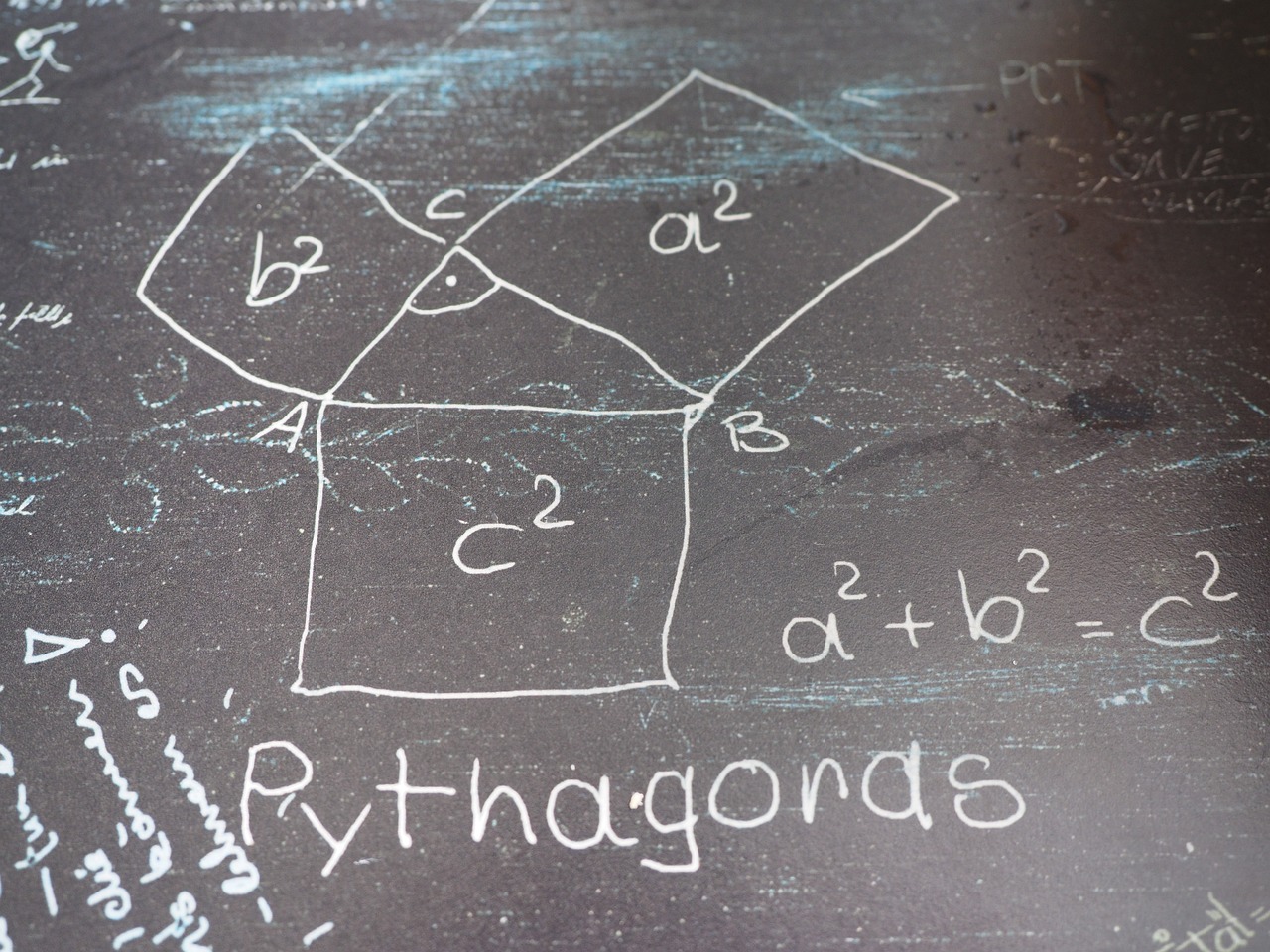

Una vez que se tienen las coordenadas de los dos puntos, se utiliza la fórmula de la distancia, que se deriva del teorema de Pitágoras. Esta fórmula se expresa de la siguiente manera:

d = √((x2 - x1)² + (y2 - y1)²)

Donde d representa la distancia entre los dos puntos, x1 e y1 son las coordenadas del primer punto, y x2 e y2 son las coordenadas del segundo punto.

Es importante mencionar que la distancia obtenida a través de esta fórmula siempre será un número positivo, ya que corresponde a la magnitud de la separación entre los dos puntos en el plano.

Por último, cabe destacar que existen distintas aplicaciones que utilizan el cálculo de la distancia entre puntos, como por ejemplo Google Maps, que utiliza esta fórmula para calcular el tiempo y la distancia de un recorrido entre dos puntos dados por el usuario.

¿Cómo calcular la distancia entre el origen y el punto?

Para calcular la distancia entre el origen y un punto dado, es necesario utilizar la fórmula matemática correspondiente. Si bien puede sonar complicado al principio, se trata de un cálculo bastante sencillo una vez que se entiende el proceso. A continuación, explicaremos los pasos a seguir para calcular la distancia entre el origen y cualquier punto en el plano cartesiano.

Lo primero que hay que hacer es conocer las coordenadas del punto en cuestión, ya que esto es fundamental para aplicar la fórmula adecuada. En general, un punto se expresa en el sistema de coordenadas cartesianas como (x,y), donde x representa la posición horizontal y y la posición vertical.

Una vez que se conocen las coordenadas del punto, se puede proceder a calcular la distancia entre este punto y el origen (0,0). Para ello, se utiliza la fórmula D = √(x² + y²), donde D representa la distancia entre los dos puntos, y x e y son las coordenadas del punto en cuestión. Es importante tener en cuenta que esta fórmula se basa en el teorema de Pitágoras, por lo que es necesario aplicarlo correctamente para obtener el resultado correcto.

Por ejemplo, si queremos calcular la distancia entre el origen y el punto (3,4), simplemente tenemos que sustituir los valores correspondientes en la fórmula: D = √(3² + 4²). Aplicando el teorema de Pitágoras, podemos ver que D = √(9 + 16) = √25 = 5. Por lo tanto, la distancia entre el origen y el punto (3,4) es de 5 unidades.

En resumen, calcular la distancia entre el origen y cualquier punto en el plano cartesiano es un proceso sencillo que se puede realizar de forma rápida y eficiente con la fórmula D = √(x² + y²). Solo es necesario conocer las coordenadas del punto en cuestión y aplicar la fórmula adecuadamente para obtener el resultado deseado. Con este cálculo, es posible determinar la longitud del segmento que une el origen con el punto, lo que resulta muy útil en muchas aplicaciones matemáticas y científicas.